背景

Deepseek是2025年初最火的项目,其蒸馏模型可以实现低成本而高质量的推理因此受到追捧,询问Deepseek得到其优点如下:

- 模型性能对标国际顶尖水平

DeepSeek V3采用自主研发的MoE(混合专家)架构,参数量达671B,激活token数37B,在推理效率、训练成本等方面对标GPT-4o,并首次大规模应用FP8混合精度训练策略,将训练成本控制在557万美元,训练周期缩短至2个月1。

- 多模态与跨领域能力

DeepSeek Janus-Pro模型统一了图像理解与生成的架构,性能超越DALL·E 3等国际竞品1。此外,DeepSeek还开源了多个模型,包括代码模型(DeepSeek Coder)、数学模型(DeepSeek Math)和多模态模型(DeepSeek-VL)12。

- 强化学习优化推理能力

DeepSeek R1系列通过强化学习(RL)大幅提升推理能力,达到与OpenAI相当的水平

目前Deepseek版本发展如下:

- 1)DeepSeek LLM(2024年1月)

首个大语言模型,标志着 DeepSeek 正式进入 AI 大模型领域。

在 MMLU、DROP、Codeforces 等基准测试中表现优异,超越部分竞品2。

主要应用于文本生成、代码补全等任务。

- 2)DeepSeek V3(2024年5月)

开源发布,采用 MoE(混合专家)架构,参数量达 671B,激活 token 数 37B。

训练成本仅 557 万美元,远低于 OpenAI 同类模型,大幅降低 AI 技术门槛2。

在推理效率、多轮对话、代码生成等任务上表现突出,对标 GPT-42。

- 3)DeepSeek-R1(2025年初)

开源 660B 参数模型,优化推理能力,降低算力需求3。

采用 强化学习(RL)优化,推理性能接近闭源头部模型3。

支持 多模态任务,如图像理解与生成(Janus-Pro 模型)3。

- 4)DeepSeek-V3(2025年)

总参数超 600B,运算速度更快,兼容 OpenAI API 格式,便于开发者迁移7。

在 手机端 App 落地,支持智能问答、文件解析、创意写作等功能7。

日活跃用户(DAU)突破 2161 万,成为全球增速最快的 AI 应用之一5。

- 5)DeepSeek 蒸馏版本(1.5B~32B)

适用于 本地化部署,如华为 ModelEngine 平台支持一键部署4。

在 证券、智能制造、能源等行业 显著降低运维成本(如某证券公司成本下降 42%)4。

- 6)DeepSeek 多模态模型(Janus-Pro)

解耦 图像理解与生成,性能超越 DALL·E 33。

适用于 AI 绘画、设计、广告创意 等领域4。

第一步:安装Ollama

Ollama 是一个开源工具,专门用于在本地运行、管理和部署大型语言模型(LLMs,Large Language Models)。它简化了

LLMs 的安装、配置和运行流程,支持多种流行的开源模型(如 LLaMA、Mistral、DeepSeek

等),适合开发者和研究人员在本地环境中快速实验和开发。

Ollama的官网地址为:https://ollama.com,Linux、Windows和MacOS都有相应的支持。按照官网的Linux下载方式,Ubuntu24.04的安装如下:

curl -fsSL https://ollama.com/install.sh | sh

有类似于这样的报错信息:

找不到命令 “curl”,但可以通过以下软件包安装它: sudo snap install curl # version 8.12.1,

or sudo apt install curl # version 8.5.0-2ubuntu10.6

没安装curl,安装curl:

sudo apt install curl

如果出下以下报错信息,则可能是github访问出现问题,请更改网络或挑时段下载安装:

curl: (22) The requested URL returned error: 403

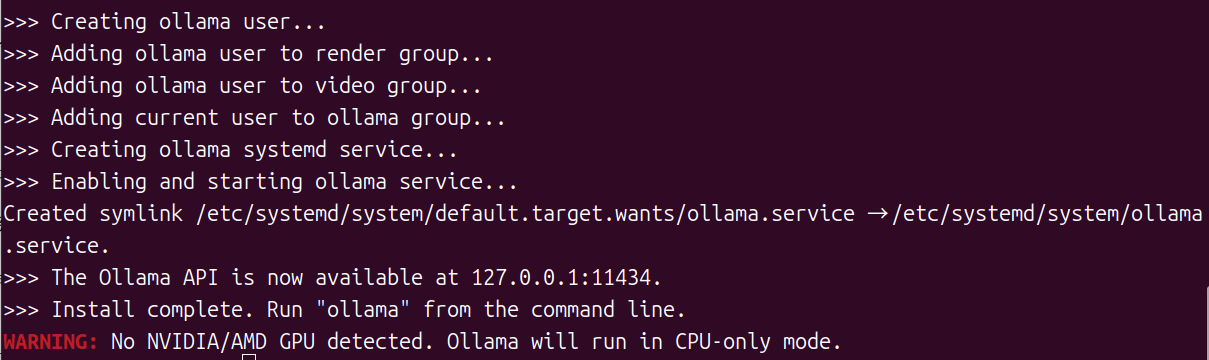

如果出现如下信息,表示安装完成。(样机没有显卡)

可以验证一下安装结果:

$ ollama --help

Large language model runner

Usage:

ollama [flags]

ollama [command]

Available Commands:

serve Start ollama

create Create a model from a Modelfile

show Show information for a model

run Run a model

stop Stop a running model

pull Pull a model from a registry

push Push a model to a registry

list List models

ps List running models

cp Copy a model

rm Remove a model

help Help about any command

Flags:

-h, --help help for ollama

-v, --version Show version information

Use "ollama [command] --help" for more information about a command

这就说明Ollama安装成功了。

第二步:下载安装deepseek

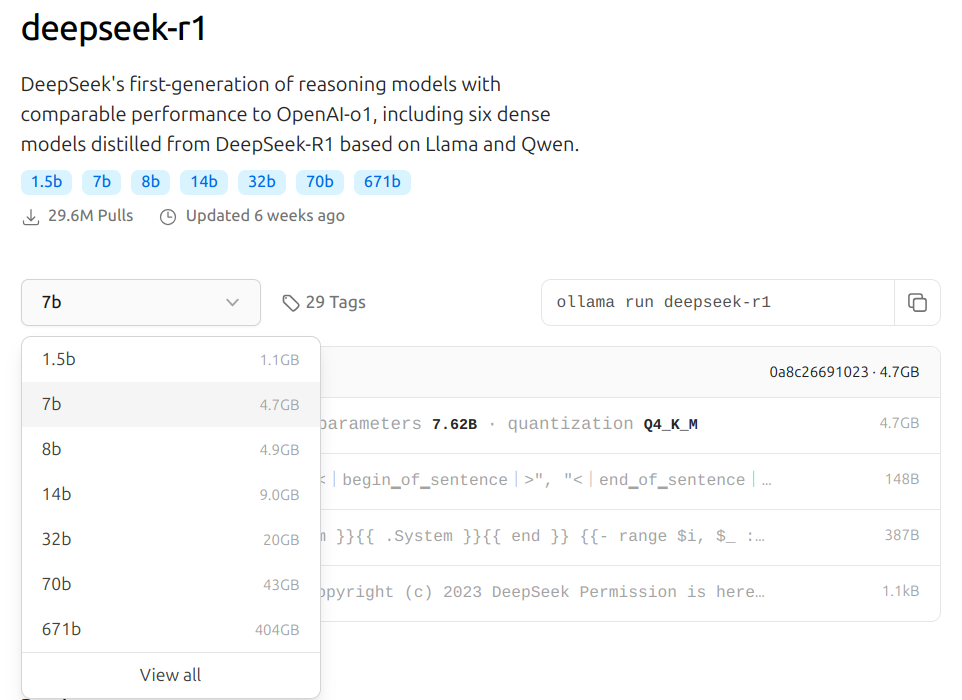

Ollama拉取和使用模型的操作跟Docker很像。Ollama官方的模型库中的DeepSeek-R1:https://ollama.com/library/deepseek-r1

可以看自己机器的配置安装相应的版本,一般机器勉强可运行7B或8B,太高ufans.top不建议。

打开终端,输入:

ollama pull deepseek-r1:7b

出现如下界面:

ollama pull deepseek-r1:7b

pulling manifest

pulling 9801e7fce27d... 100% ▕███████████████████████████████████████████████████████▏ 404 GB

pulling 369ca498f347... 100% ▕███████████████████████████████████████████████████████▏ 387 B

pulling 6e4c38e1172f... 100% ▕███████████████████████████████████████████████████████▏ 1.1 KB

pulling f4d24e9138dd... 100% ▕███████████████████████████████████████████████████████▏ 148 B

pulling fdf3d6cb73c7... 100% ▕███████████████████████████████████████████████████████▏ 497 B

verifying sha256 digest

writing manifest

success

表示成功。

运行deepseek(ufans.top以下以1.5b版本演示):

ollama run deepseek-r1:1.5b

这个时候终端窗口已经可以实现对话了。

也可以安装多个模型,切换使用。

第三步:下载安装AnythingLLM

终端对话始终局限很大,官方提供很多种方式可以实现人机对话界面,包括建立网页对话方式(可以通过docker快速搭建),也可以使用通用工具如chatbox,这里推荐AnythingLLM。

对于本地部署而言,Anything LLM可以接受各种格式的外部资料,比如PDF、Word(DOC、DOCX)、TXT 、PPT、Excel等,还支持URL检索,企业内部文档几乎都可以完美支持,因此是最佳选择。

对于ubuntu24.04而言Anything LLM安装方法:

命令安装,终端输入:

curl -fsSL https://cdn.anythingllm.com/latest/installer.sh | sh

运行:安装目录下的start

如果出现错误:

[128253:0325/093731.645293:FATAL:setuid_sandbox_host.cc(158)]

The SUID sandbox helper binary was found, but is not configured

correctly. Rather than run without sandboxing I'm aborting now. You

need to make sure that

/home/mrcan/AnythingLLMDesktop/anythingllm-desktop/chrome-sandbox is

owned by root and has mode 4755. 追踪或断点陷阱 (核心已转储)

碰到经典的沙盒问题,解决的方法有两种:

1)查看错误提示中chrome-sandbox路径,确保chrome-sandbox文件的所有者是root用户,并且具有4755权限。

sudo chown root /home/mrcan/AnythingLLMDesktop/anythingllm-desktop/chrome-sandbox

sudo chmod 4755 /home/mrcan/AnythingLLMDesktop/anythingllm-desktop/chrome-sandbox

之后再运行安装目录里start即可:/home/mrcan/AnythingLLMDesktop/start

2)在安装目录里/home/mrcan/AnythingLLMDesktop/anythingllm-desktop下,加入--no-sandbox参数终端运行

anythingllm-desktop --no-sandbox

第四步:基于AnythingLLM搭建本地库及使用

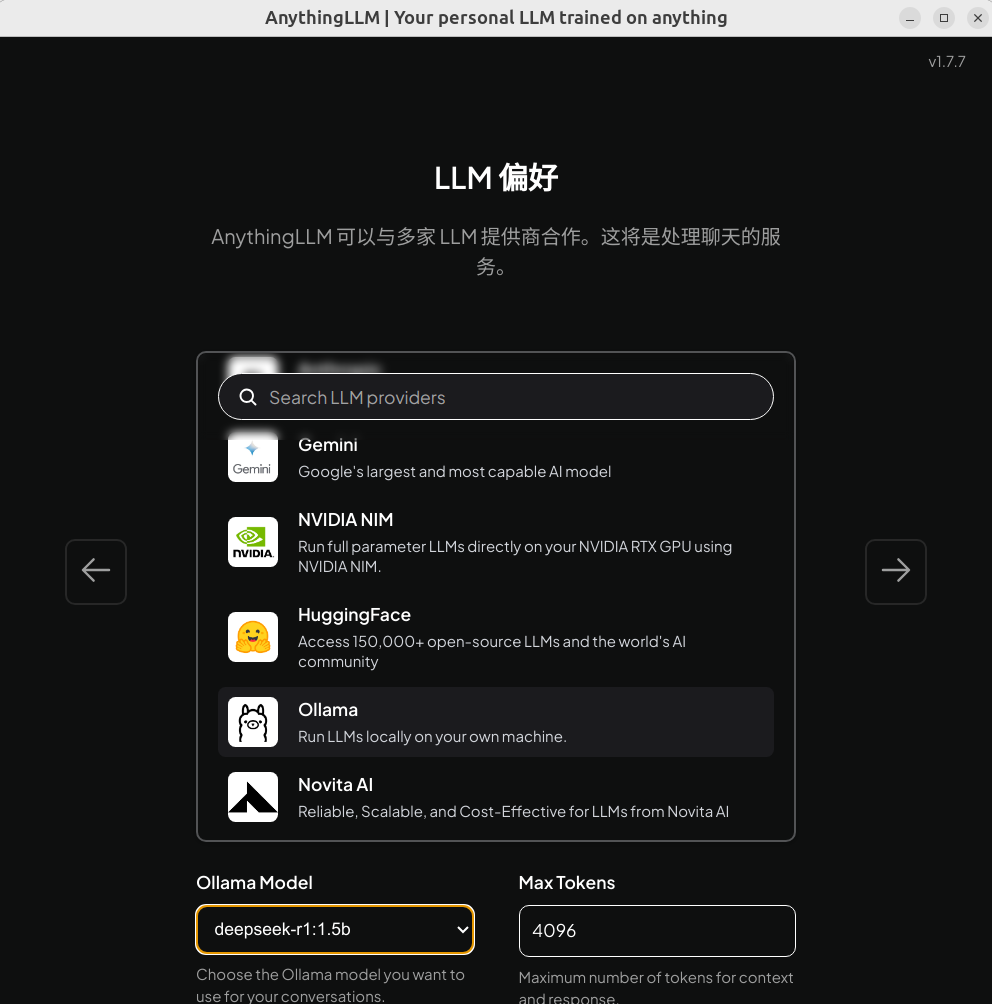

1)进入AnythingLLM选择Ollama中的本地模型,选择下一步

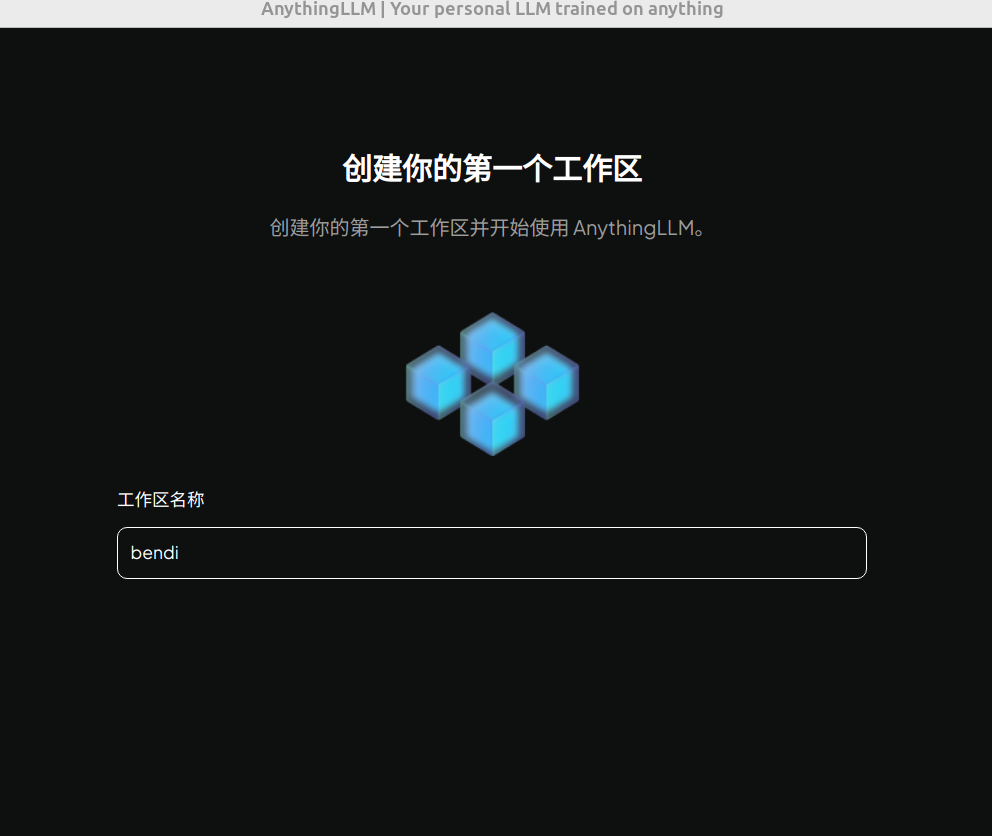

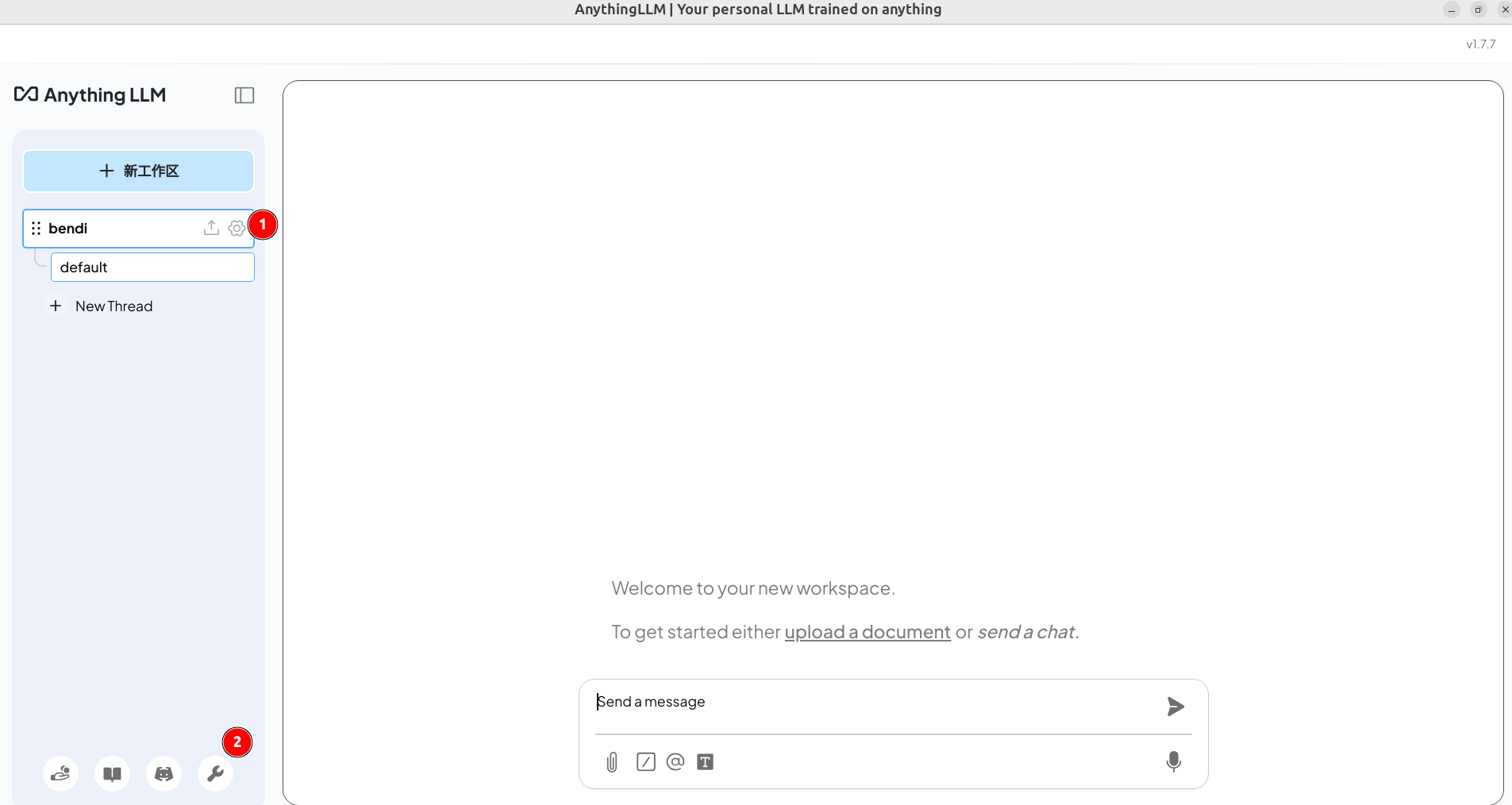

2)选下一步跳过调查,工作区命名:

3)进入工作区界面后,如下图:1处的设置可以调整本工作区参数;2处的设置调整所有设置参数。

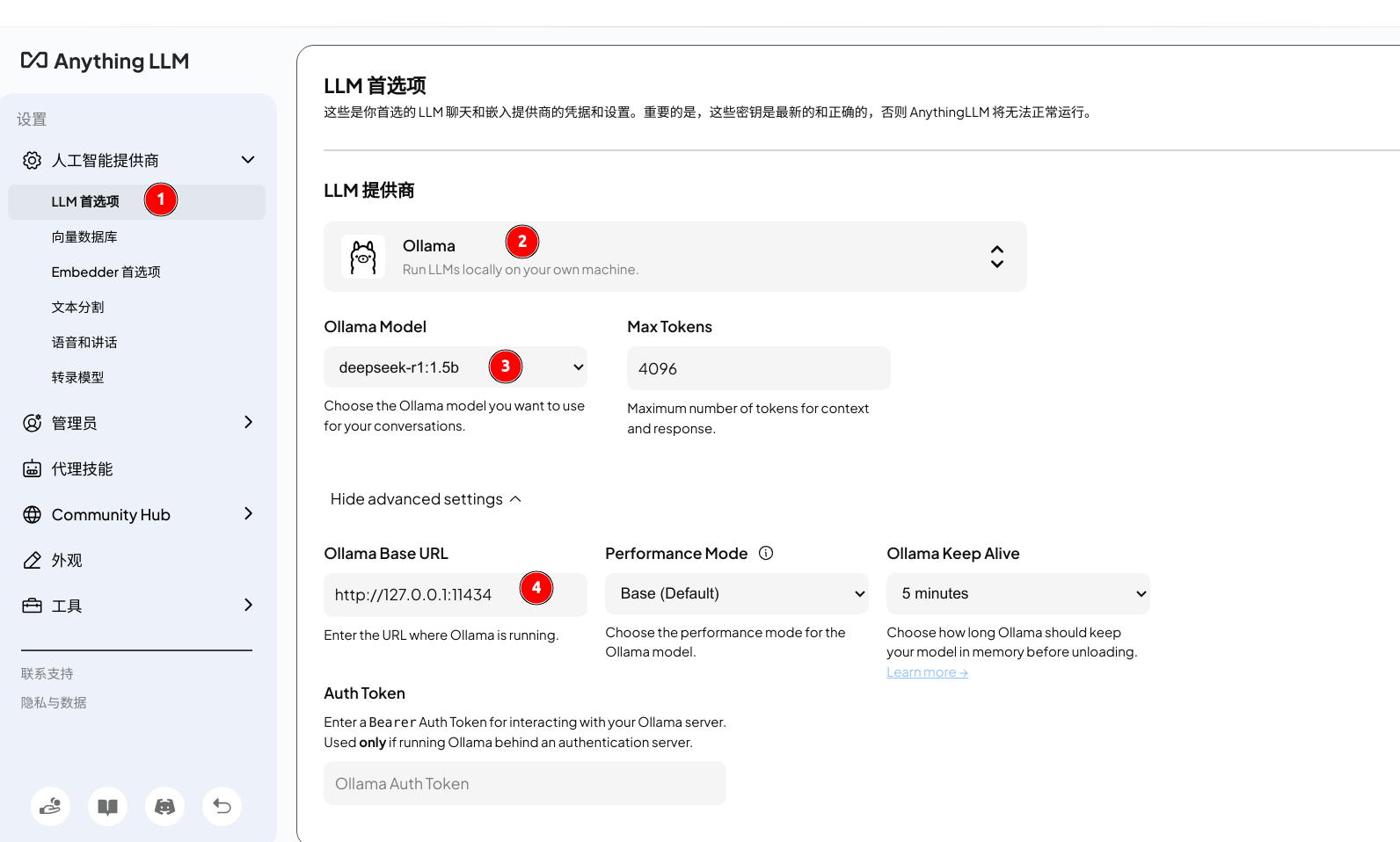

4)选择2处设置,改为中文设置及界面底色后进入“人工智能提供商”设置界面查看本地deepseek是否设置正确。

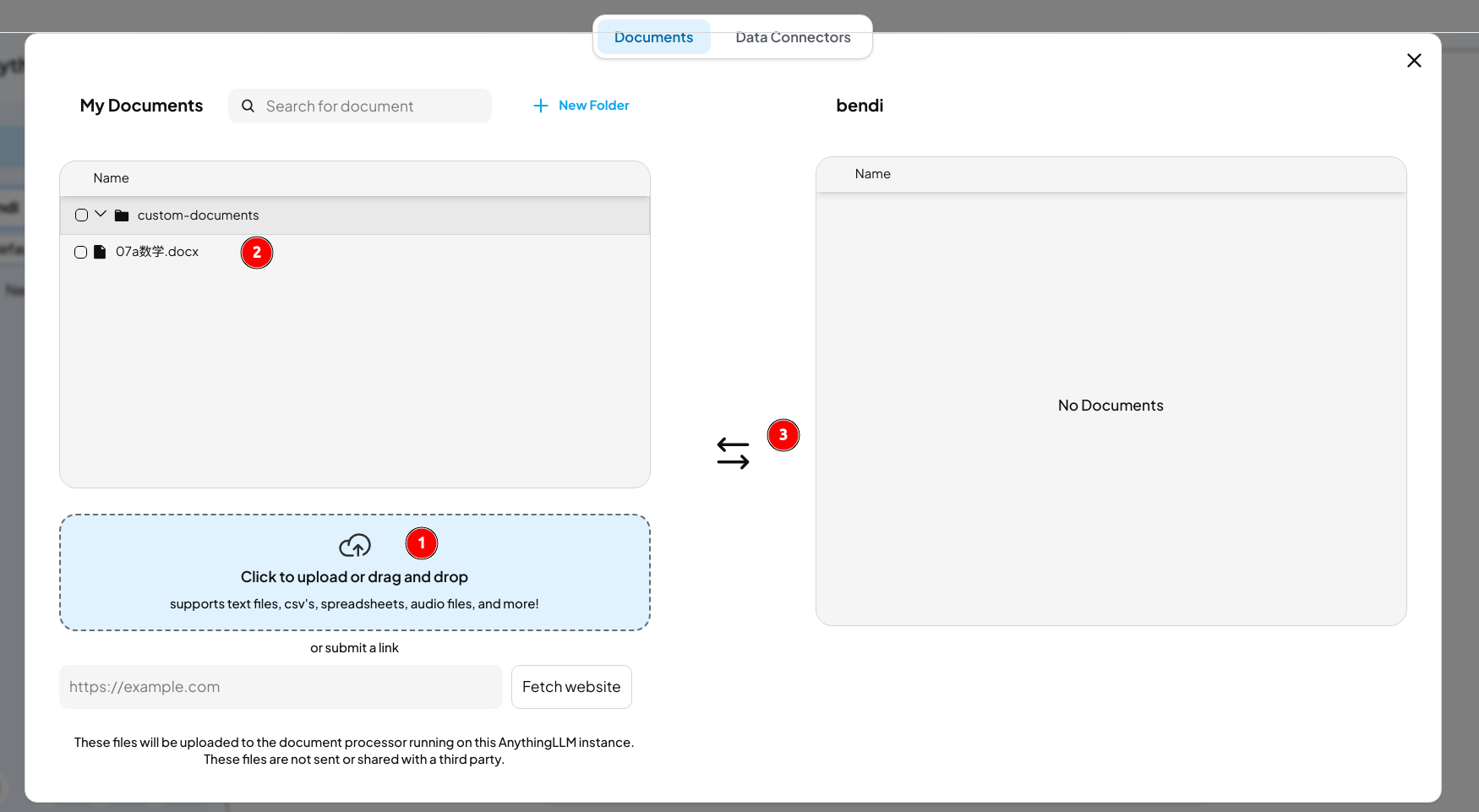

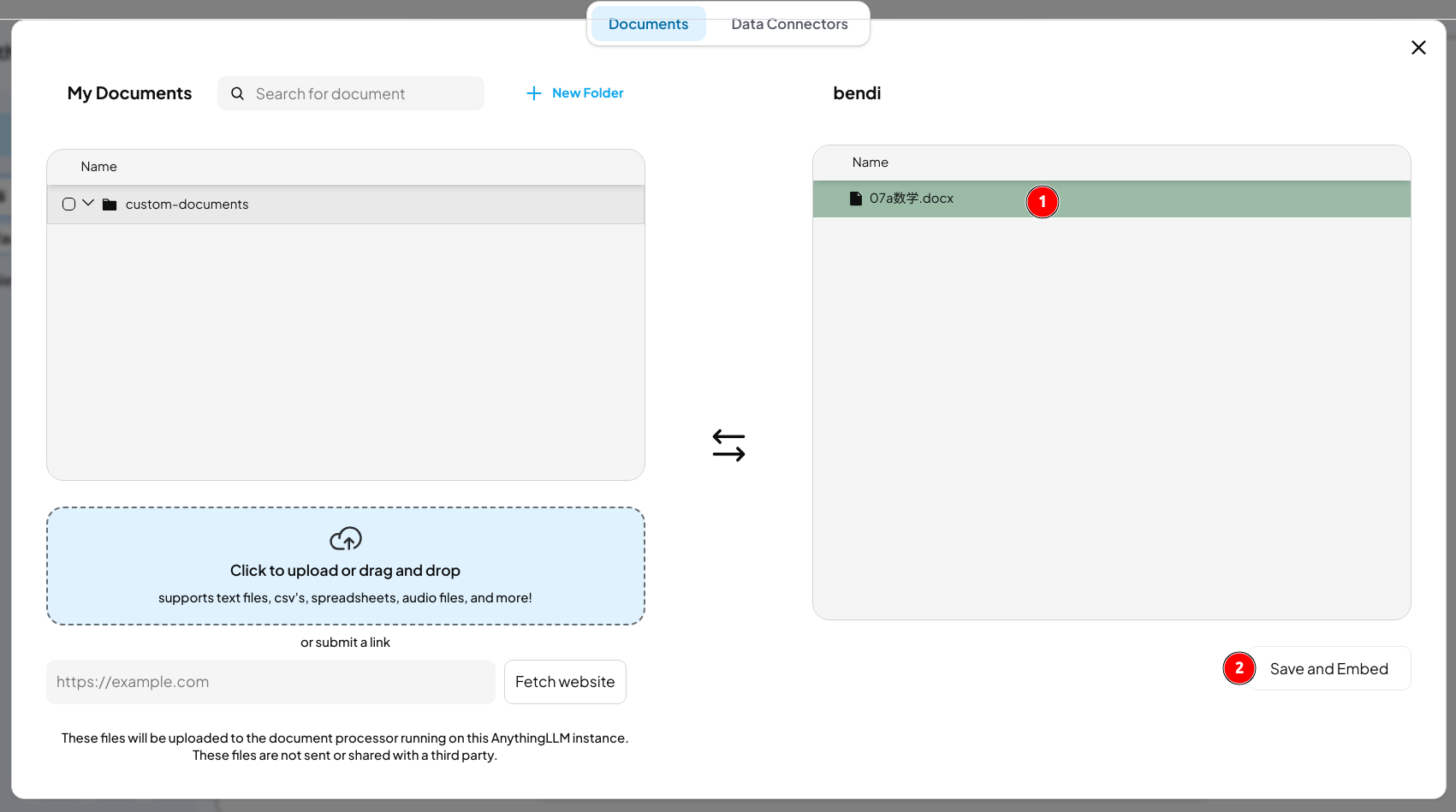

5)点击工作区的上传图标,上传本地文档搭建本地知识库;如下图所示,上传完毕后转入工作区。

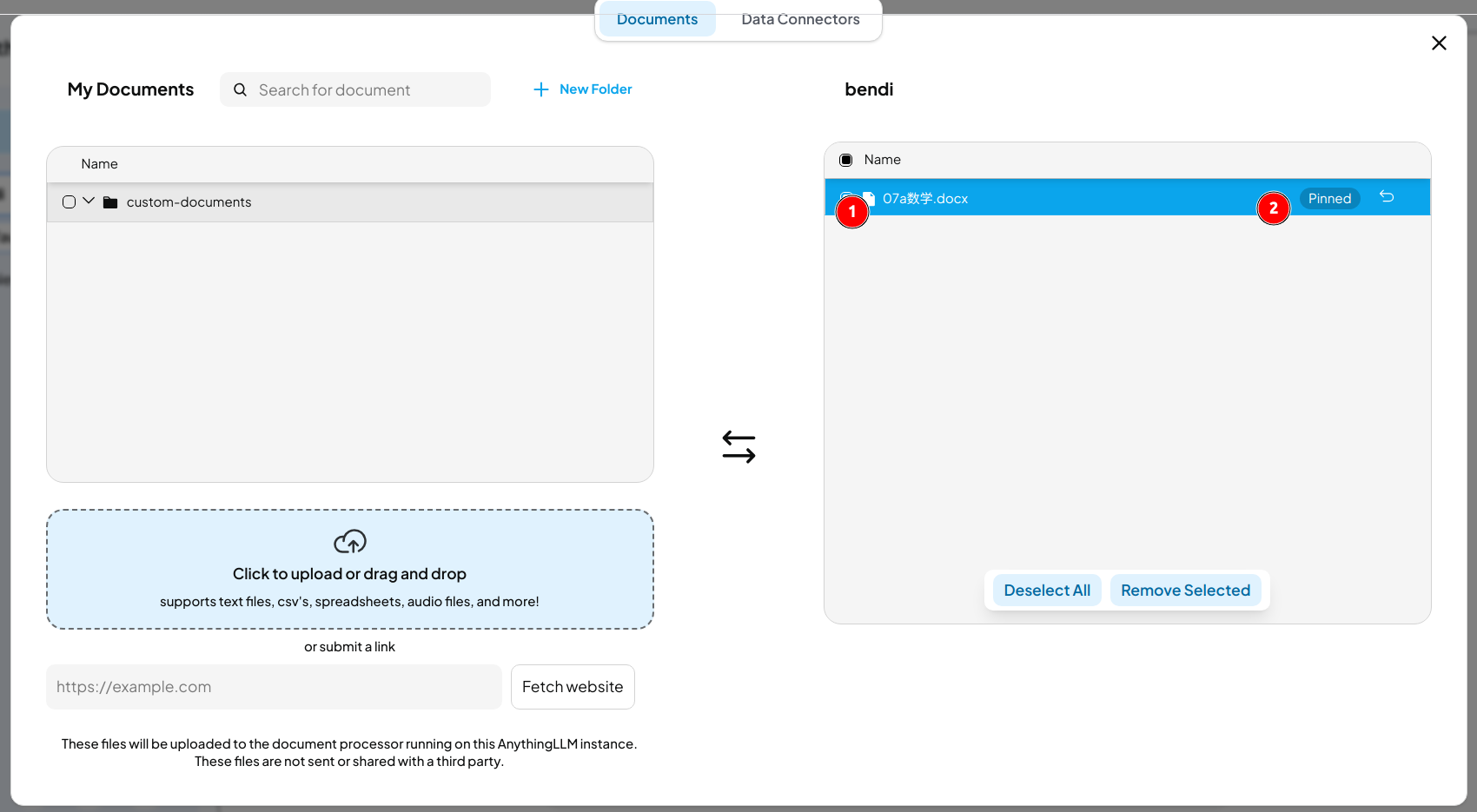

6)工作区中选择所要文档,点击"Save and Embed"完成,选择所学文档,并点击pin按钮,显示pinned后即可在对话中学习文档内容。

更多用法参考AnythingLLM官方文档。