近年来Ubuntu的母公司Canonical与NVIDIA合作不断加深,如通过NVIDIA 企业级AI工厂认证;为NVIDIA AI Enterprise 4.0 提供Ubuntu KVM Hypervisor 支持;宣布将在 Ubuntu 存储库中打包和分发 NVIDIA CUDA 工具包,CUDA 工具包是英伟达为开发者提供的并行计算平台和编程模型,可以利用英伟达 GPU 进行通用处理。

因此,基于Ubuntu进行AI开发无疑是目前最佳的平台。

不过到目前为止开发者必须从英伟达官网下载 CUDA 工具包才能在 Ubuntu 上安装,Canonical尚未公布在 Ubuntu 存储库中打包和分发 CUDA 工具包的具体可操作时间。

ufans.top将详细介绍在Ubuntu24.04中配置NVIDIA驱动、CUDA和Docker的GPU支持方法。

一.安装NVIDIA GPU驱动

如果Ubuntu系统安装时选择在线更新,大部分系统会自动安装好NVIDIA GPU驱动,除非特别新(超过该ubuntu版本发行时间太多)的显卡。无论如何都可以通过如下方式进行安装和更新。

1)添加官方的驱动库

sudo add-apt-repository ppa:graphics-drivers/ppa

sudo apt update

2)安装依赖包

sudo apt install -y alsa-utils

sudo apt install -y pciutils ubuntu-drivers-common

如果还有需补全运行:

sudo apt -f install

3)检测GPU并安装最佳驱动

# 检查系统中的NVIDIA显卡

lspci | grep -i nvidia

# 查看推荐的驱动

sudo ubuntu-drivers devices

# 安装推荐的NVIDIA驱动(开源内核模块版本)

sudo apt install nvidia-driver-570-open

安装完成后重启系统,运行:

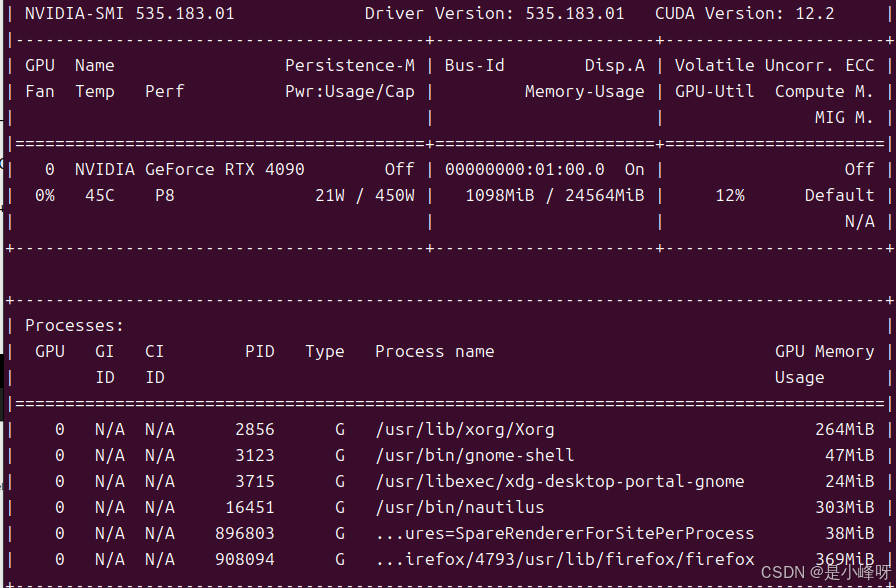

nvidia-smi

如果安装正常,会显示如下:

二.安装CUDA工具套件

方法一:

1)添加NVIDIA CUDA仓库

# 下载并安装CUDA仓库密钥

wget https://developer.download.nvidia.com/compute/cuda/repos/ubuntu2404/x86_64/cuda-keyring_1.1-1_all.deb

sudo dpkg -i cuda-keyring_1.1-1_all.deb

2)安装CUDA 13.0工具套件

sudo apt-get -y install cuda-toolkit-13-0

3)配置环境变量

echo 'export PATH=/usr/local/cuda-13.0/bin${PATH:+:${PATH}}' >> ~/.bashrc

echo 'export LD_LIBRARY_PATH=/usr/local/cuda-12.8/lib64${LD_LIBRARY_PATH:+:${LD_LIBRARY_PATH}}' >> ~/.bashrc

source ~/.bashrc

4)验证CUDA安装

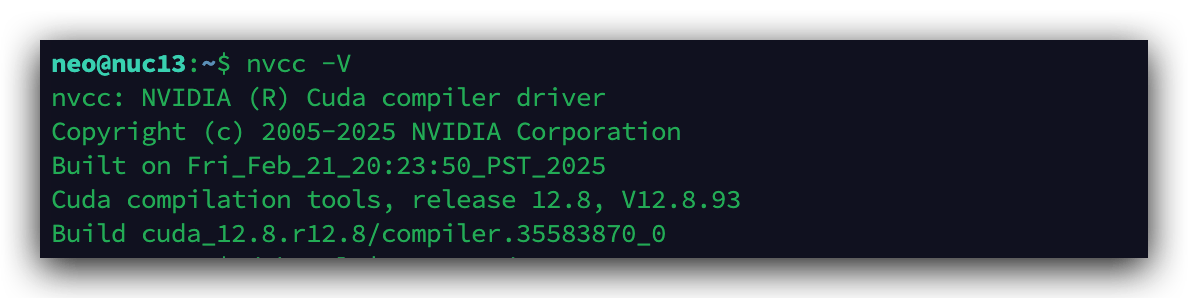

nvcc -V

正确安装后,你将看到CUDA编译器版本信息:

方法二:

下载linux版本的run文件安装。

wget https://developer.download.nvidia.com/compute/cuda/13.0.1/local_installers/cuda_13.0.1_580.82.07_linux.run

sudo sh cuda_13.0.1_580.82.07_linux.run

安装时注意选择。

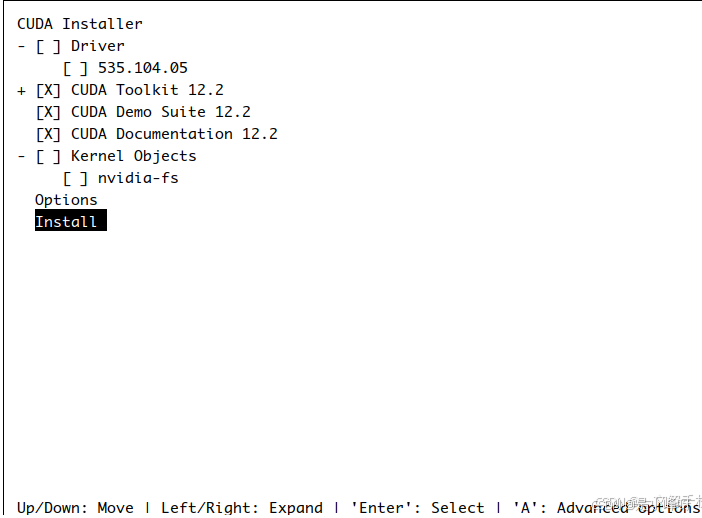

注意:在这里,按“空格”键取消Driver,因为前面已经安装过驱动,再次安装可能出现冲突。然后选择“Install”

配置方法同上:

export PATH=$PATH:/usr/local/cuda-13.0/bin

export LD_LIBRARY_PATH=$LD_LIBRARY_PATH:/usr/local/cuda-13.0/lib64

export CUDA_HOME=$CUDA_HOME:/usr/local/cuda-13.0

source ~/ .bashrc

注意实际根据版本选择路径名。

三.安装cuDNN库

cuDNN是深度学习框架的核心加速组件,有了它,TensorFlow、PyTorch等框架才能充分发挥GPU性能

1)安装cuDNN库

wget https://developer.download.nvidia.com/compute/cudnn/9.13.1/local_installers/cudnn-local-repo-ubuntu2404-9.13.1_1.0-1_amd64.deb

sudo dpkg -i cudnn-local-repo-ubuntu2404-9.13.1_1.0-1_amd64.deb

sudo cp /var/cudnn-local-repo-ubuntu2404-9.13.1/cudnn-*-keyring.gpg /usr/share/keyrings/

sudo apt-get -y install cudnn

注意安装与cuda匹配的版本

sudo apt-get -y install cudnn9-cuda-13

或

sudo apt-get -y install cudnn9-cuda-12

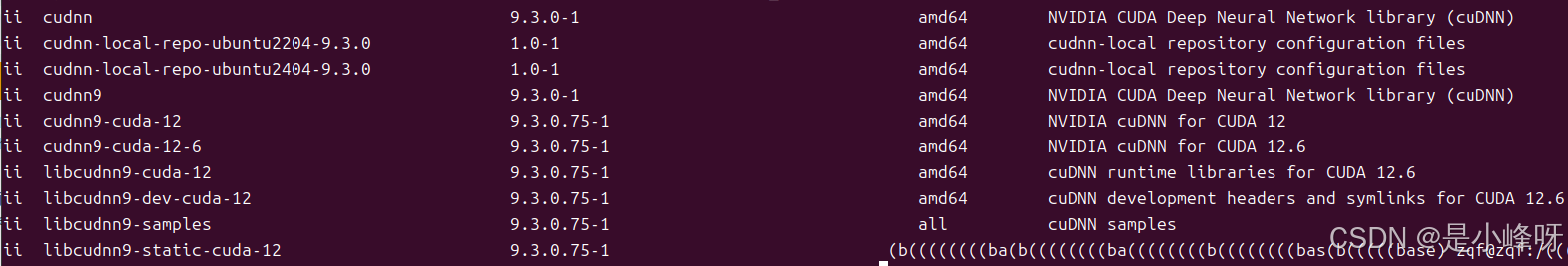

2)检查cuDNN版本

dpkg -l | grep cudnn

四.安装NVIDIA Container Toolkit

在使用Docker运行需要GPU加速的AI应用时,可能会遇到报错:

docker: Error response from daemon: could not select device driver ""

with capabilities: [[gpu]]

这是因为缺少 NVIDIA Container Toolkit —— 它是让容器访问宿主GPU的关键桥梁。

# 添加密钥和仓库

curl -fsSL https://nvidia.github.io/libnvidia-container/gpgkey | sudo gpg --dearmor -o /usr/share/keyrings/nvidia-container-toolkit-keyring.gpg

curl -s -L https://nvidia.github.io/libnvidia-container/stable/deb/nvidia-container-toolkit.list | \

sed 's#deb https://#deb [signed-by=/usr/share/keyrings/nvidia-container-toolkit-keyring.gpg] https://#g' | \

sudo tee /etc/apt/sources.list.d/nvidia-container-toolkit.list

# 安装NVIDIA Container Toolkit

sudo apt-get update

sudo apt-get install -y nvidia-container-toolkit

安装完后可进行配置。

五.配置Docker运行时

Docker的安装在此省略。配置如下:

# 生成配置文件

sudo nvidia-ctk runtime configure --runtime=docker

# 重启Docker服务

sudo systemctl restart docker

验证GPU在Docker中可用

sudo docker run --rm --gpus all nvidia/cuda:12.8.0-base-ubuntu24.04 nvidia-smi

完毕。