2025年1月20日,DeepSeek推出了AI模型R1,推出后不久,R1就凭借其性价比、开源及推理能力的提升等方面获得了广泛关注。DeepSeek表示,最新的AI模型可以与OpenAI的ChatGPT媲美,且开发成本远低于竞争产品。

市场人士称,DeepSeek的R1大型语言模型或引发行业重估大模型成本。华尔街开始考虑科技行业巨头对AI基础设施的巨额投资以及对英伟达芯片的需求是否合理。其性能可媲美OpenAI开发的GPT-o1,但成本却远小于对方。DeepSeek在App Store的下载量已于27日超过ChatGPT。在美国,英伟达下跌11%,微软、Meta、Alphabet跌超3%。在欧洲,ASML下跌7.5%,西门子能源下跌近18%。在日本,参与美国“星际之门”投资的软银跌超8%。

环球时报1月27日称,Deepseek被认为是大模型行业的最大“黑马”,在外网被不少人称为“神秘的东方力量”。

在发布开源模型 DeepSeek-R1 之后,因其出色的性能和低廉的成本,DeepSeek 引起了广泛关注,其应用“DeepSeek - AI Assistant(或 DeepSeek - AI 助手)”也迅速进入应用商店的排行榜前列。在苹果应用商店的美区和国区,DeepSeek 进入了免费应用排行榜的第一名。在 Google Play 应用商店,DeepSeek 排在免费生产力应用第二名。DeepSeek-R1 的推理性能接近 OpenAI-o1-1217,该公司研究人员也在预印本平台 arXiv 上发表论文,介绍了通过增强学习大幅提升大模型推理能力的方法。

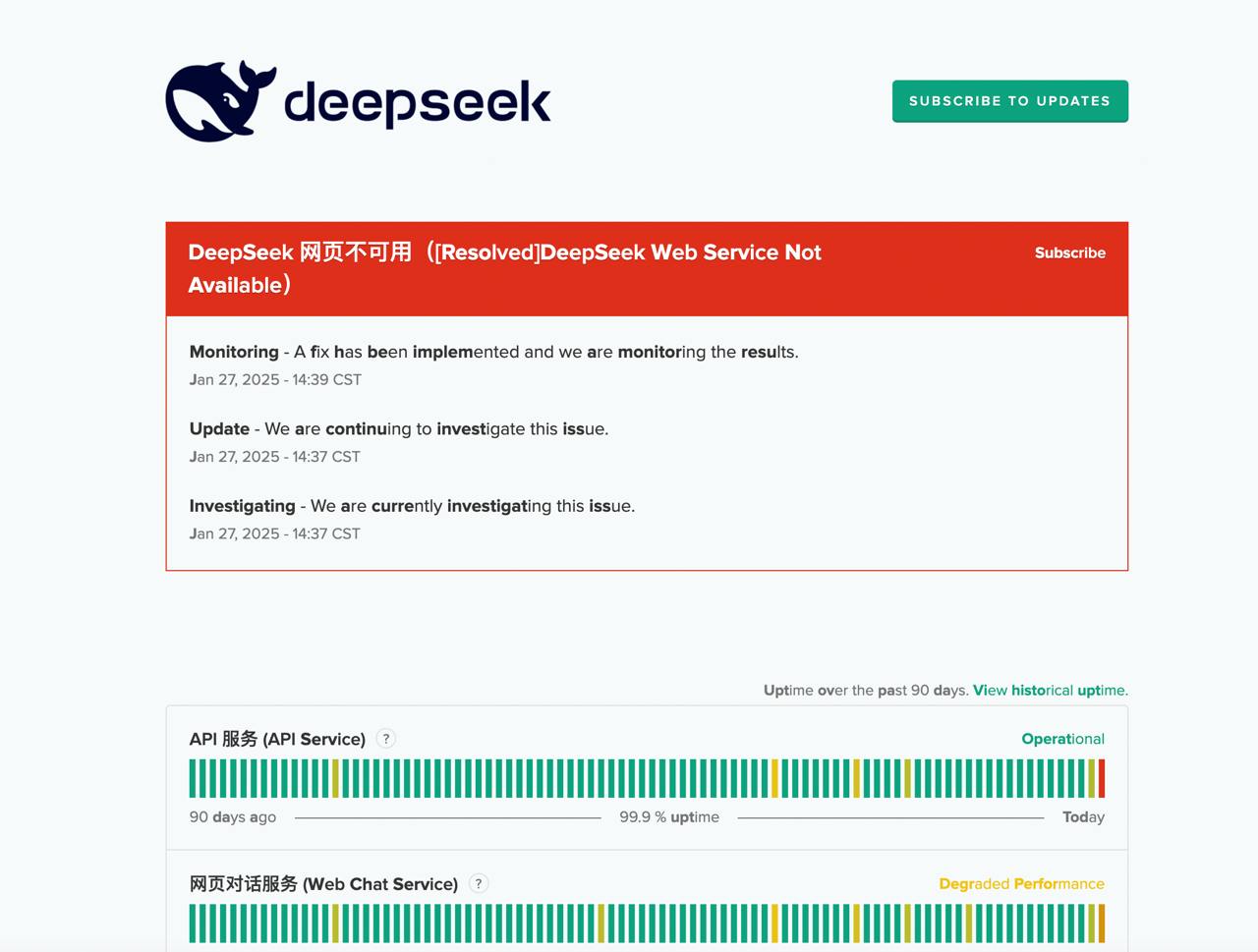

在海外出圈之后,DeepSeek的服务需求激增。此前据媒体报道,DeepSeek旗下AI(人工智能)服务经历了多次宕机,可能与新模型发布后的访问量激增有关。

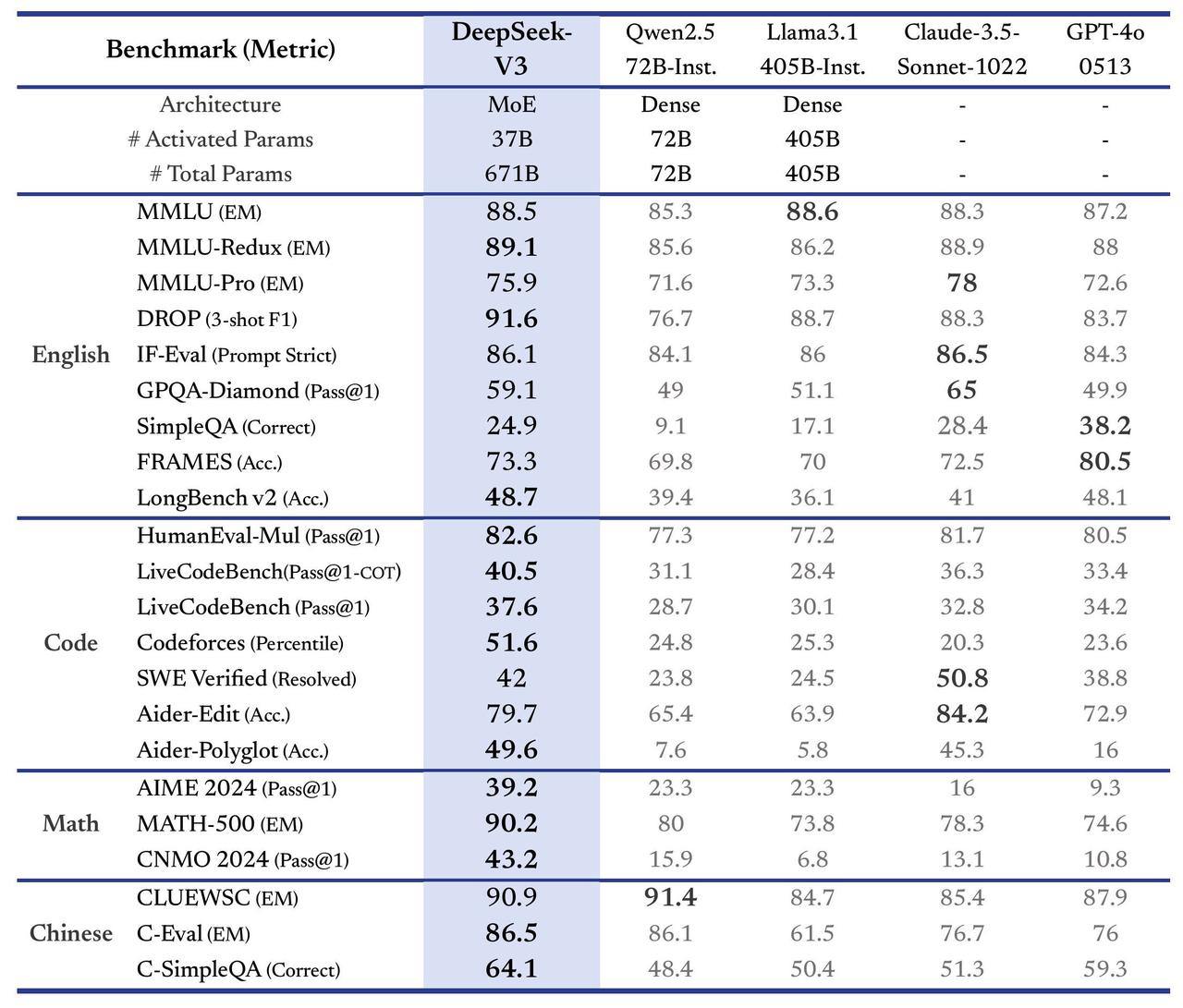

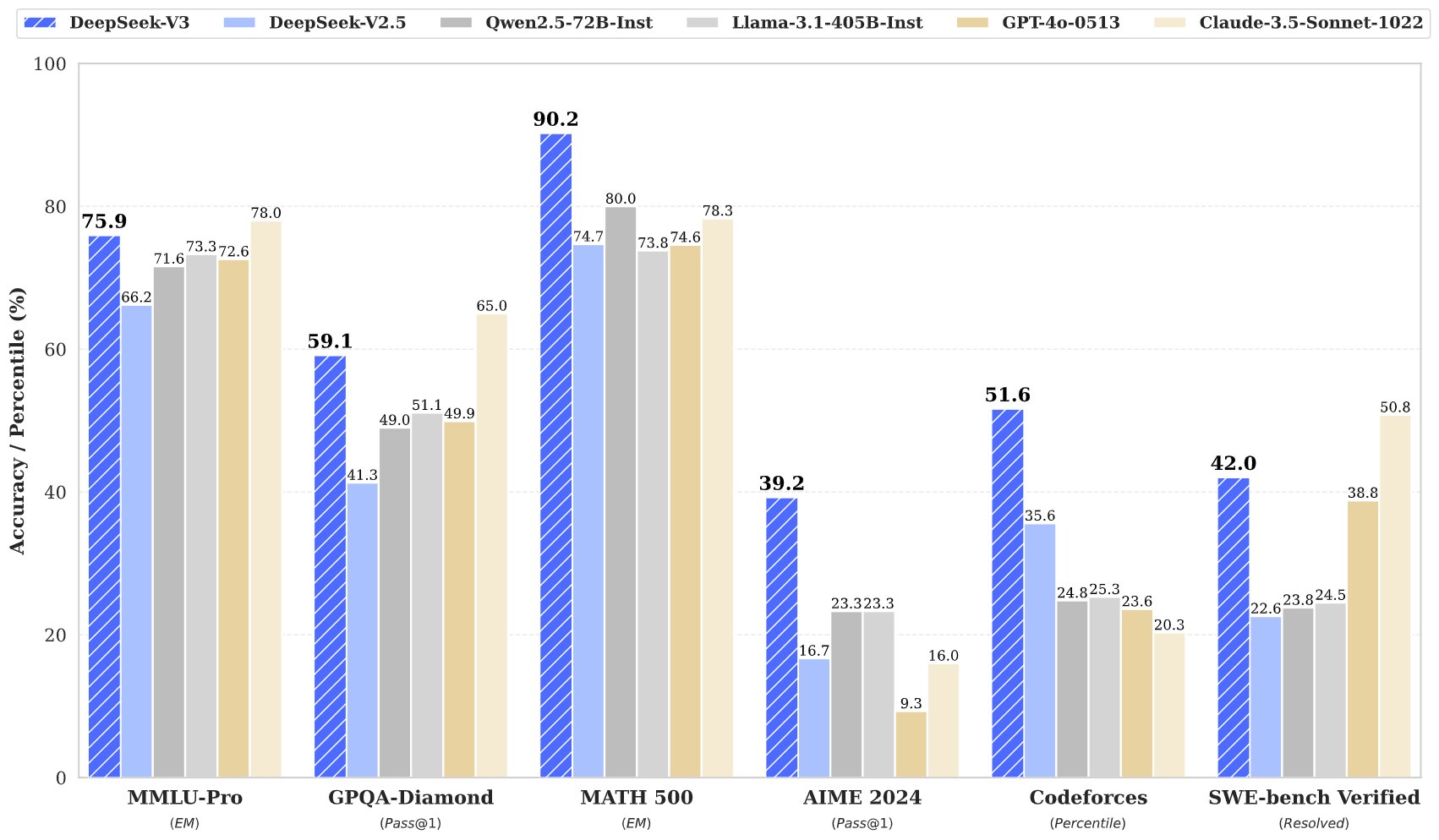

DeepSeek-V3据官方介绍这是一个强大的混合专家 (MoE) 语言模型,总共有 671B 个参数,每个 token 激活 37B。为了实现高效的推理和经济高效的训练,DeepSeek-V3 采用了多头潜在注意力 (MLA) 和 DeepSeekMoE 架构,这些架构在 DeepSeek-V2 中得到了彻底的验证。此外,DeepSeek-V3 开创了一种无辅助损失的负载平衡策略,并设置了多 token 预测训练目标以获得更强大的性能。在 14.8 万亿个多样化和高质量的 token 上对 DeepSeek-V3 进行了预训练,然后进行监督微调和强化学习阶段,以充分利用其功能。综合评估表明,DeepSeek-V3 优于其他开源模型,并实现了与领先的闭源模型相当的性能。尽管性能出色,但 DeepSeek-V3 仅需要 2.788M H800 GPU 小时即可完成完整训练。此外,它的训练过程非常稳定。测试与对比如下: